La teoria evoluzionistica di Charles Darwin è ancora oggi un caposaldo per interpretare i processi di cambiamento.

Nel 1859, On the Origin of Species di Charles Darwin, fu la prima pubblicazione a fornire una teoria completa sulle dinamiche del cambiamento. Da allora, l’approccio darwiniano è stato utilizzato in tutti i campi della conoscenza per spiegare i meccanismi di evoluzione e adattamento: persino molti dei moderni algoritmi di Intelligenza Artificiale sono stati sviluppati seguendo una filosofia evoluzionistica.Per sviluppare la sua teoria, Charles Darwin adottò un approccio multidisciplinare, prendendo spunto da varie discipline. Principles of Geology (1830) di Charles Lyell lo avvicinò al concetto di gradualismo (piccole cause, accumulate su periodi molto lunghi, possono avere effetti importanti: in Lyell il gradualismo era applicato all’erosione delle rocce); l’Essay on the Principle of Population (1798) di Thomas Malthus portò l’attenzione di Darwin al fatto che la crescita della popolazione spingesse alla competizione per il cibo e per le altre risorse (Darwin estese poi il concetto a tutte le specie viventi); infine il saggio di Adam Smith The Wealth of Nations (1776) lo avvicinò alla teoria della mano invisibile (“invisible hand”) ossia il fatto che una serie di individui che agiscono per finalità personali producono il massimo beneficio per la comunità in assenza di un decisore centrale.

L’evoluzione tramite selezione naturale

I principi della teoria darwiniana dell’evoluzione possono essere riassunti in 4 punti principali:

- tutte le specie derivano per evoluzione da un unico progenitore;

- la selezione naturale avviene quando il numero di nascite è superiore a quello consentito dalle risorse esistenti per cui i singoli individui iniziano a competere;

- le caratteristiche degli individui sono ereditate ma con alcune variazioni completamente casuali. Le variazioni che meglio si adattano all’ambiente circostante sono selezionate cioè gli organismi che le possiedono hanno più probabilità di sopravvivere e di trasmetterle alle generazioni successive;

- i cambiamenti nel processo di evoluzione sono costanti e graduali attraverso l’accumulazione nel lungo periodo di piccole variazioni favorevoli.

“Tutto va per gradi in natura, e niente procede per salti.” (Gottfried W. von Leibniz)

Come si adattano i sistemi viventi

Melanie Mitchell, studiosa di sistemi complessi, nel suo libro Complexity: A Guided Tour, spiega come le idee di Darwin possano essere utilizzate per interpretare il funzionamento dei “sistemi naturali viventi” (“natural living systems”) e nella fattispecie, per capire come questi sistemi processino le informazioni e si adattino ai cambiamenti dell’ambiente circostante in assenza di un decisore centrale.

Facciamo due esempi: il sistema immunitario e le colonie di formiche.

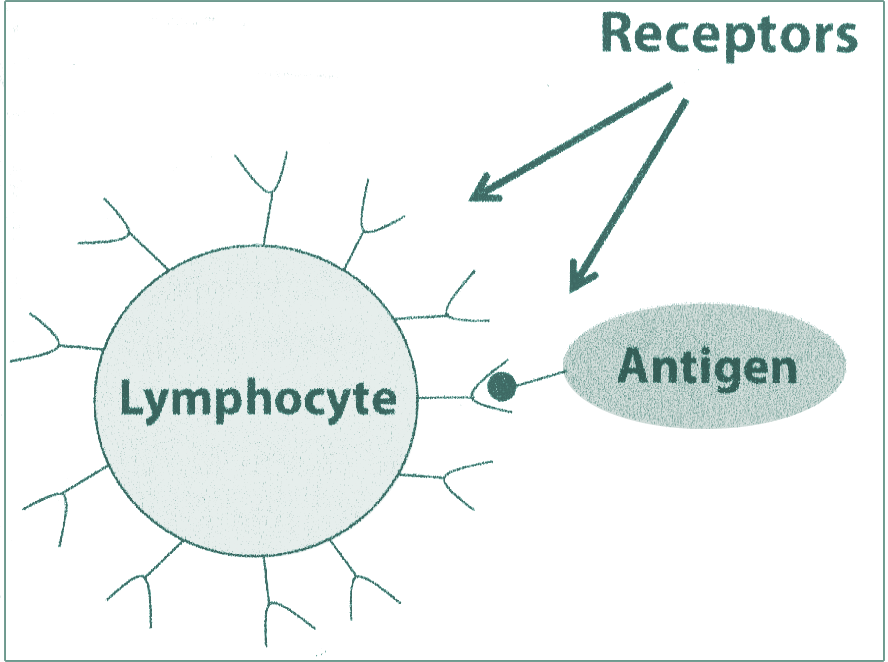

I linfociti, le cellule maggiormente coinvolte nella battaglia contro gli agenti patogeni, presentano sulla loro superficie delle molecole chiamate recettori. Quando una molecola patogena (definita “antigene”), con struttura compatibile con i recettori, entra nell’ organismo, viene legata e riconosciuta dal linfocita, il primo step per attivare il sistema immunitario (vedi figura 1).

Ci sono potenzialmente un numero astronomico di agenti patogeni che possono invadere il nostro corpo, caratterizzati da strutture molecolari tutte differenti. Come fare allora ad avere un numero sufficiente di linfociti con la struttura dei recettori compatibile a quella degli invasori?

Quando un nuovo linfocita viene generato dal midollo spinale (circa 10 milioni al giorno) un complesso processo di generazione casuale (random shuffling process) determina la forma dei recettori. Dato l’elevato turnover giornaliero, il sistema immunitario genera continuamente linfociti con nuove forme di recettori. In caso di invasione di un agente patogeno, ci vorrebbe poco tempo per generare un linfocita con una forma di recettori compatibile con quella dell’antigene, anche se, inizialmente, il legame potrebbe essere debole.

Il linfocita che intercetta e si lega all’invasore si trasferisce nei linfonodi dove si divide rapidamente generando delle cellule figlie, con mutazioni nelle strutture dei recettori. Dopo un processo di testing in cui vengono subito scartate le strutture inefficienti, solo i linfociti “figli” con recettori “adatti” vengono immessi in circolo: quando incontrano l’antigene, lo catturano legandosi in maniera più forte rispetto ai genitori e lo riportano nei linfonodi dove il processo si ripete.

E’ evidente quindi che siamo in presenza un processo evolutivo “accelerato” di selezione naturale applicato alla struttura dei recettori dei linfociti: nel giro di alcuni giorni viene creato un esercito di cellule con caratteristiche adatte alla distruzione dell’agente patogeno.

Dinamiche simili caratterizzano la ricerca di cibo in una colonia di formiche. Quando la colonia si sposta in un nuovo territorio, un elevato numero di formiche “ricercatrici” viene mandato in esplorazione in direzioni casuali. Quando una formica incontra una fonte di cibo, ritorna al nido lasciando sul percorso una traccia di feromoni. Altre formiche, imbattendosi per caso sulla traccia di feromoni, seguono lo stesso percorso fino al cibo, e tornando al nido lasciano anch’esse la propria dose di feromoni, “rinforzando” il percorso. In assenza di rinforzo (ossia altre formiche trovano la stessa fonte di cibo ma non la giudicano di buona qualità) il segnale presto svanirebbe (cioè i percorsi non “adatti” vengono eliminati velocemente); al contrario se la scoperta di cibo fosse valida, il segnale verrebbe rinforzato da altre formiche, attraendone sempre di più. In questo modo le formiche sono in grado di scambiarsi informazioni sul posizionamento e la qualità del cibo, adattandosi in maniera dinamica all’ambiente circostante.

Casualità e determinismo

Gli esempi appena descritti dimostrano come i sistemi viventi utilizzino dei processi di adattamento caratterizzati da un mix efficace di casualità e determinismo. Infatti, sia la forma dei recettori dei linfociti che i percorsi delle formiche alla ricerca del cibo sono generati casualmente per coprire il più ampio spettro di possibilità. Molti percorsi e opzioni differenti vengono esplorati in “parallelo” ma le risorse allocate alle diverse esplorazioni variano a seconda delle informazioni acquisite e continuamente aggiornate in merito alla validità di ciascuna opzione (processo deterministico di sfruttamento delle informazioni che fa evolvere solo le opzioni più adatte).

Ognuno dei miliardi di linfociti può essere considerato come una particolare mini-esplorazione di forma di recettori. Le forme che hanno maggior successo nel legarsi agli antigeni, ricevono maggiori risorse in termini di ulteriore esplorazione (parte il processo di generazione delle cellule figlie). Tuttavia, mentre “sfrutta” le informazioni che sono state acquisite, il sistema immunitario continua a generare nuovi linfociti con forme sempre diverse: il suo funzionamento si basa quindi su un bilanciamento perfetto tra sfruttamento delle informazioni acquisite ed esplorazione di nuove possibilità.

Stesso dicasi per le formiche: all’inizio partono in esplorazione casuale ma successivamente, tramite i meccanismi di feedback descritti, maggiori risorse in termini di “esploratrici” vengono allocate allo sfruttamento delle fonti di cibo più promettenti. Tuttavia, un certo numero di formiche verrà sempre allocata all’attività di esplorazione casuale: non si esclude quindi la possibile scoperta di fonti di cibo ancora migliori.

Tutti i sistemi viventi mantengono un bilanciamento tra un’attività di esplorazione (“exploration”), generalmente casuale e non focalizzata, finalizzata all’ottenimento di informazioni, e una di sfruttamento focalizzato (“exploitation”) delle conoscenze acquisite, per consentire un adattamento efficiente.

“L’evoluzione innova continuamente, ma ad ogni livello conserva gli elementi che sono ricombinati per generare le innovazioni.” (John H. Holland)

Non è un caso se una parte degli algoritmi di Intelligenza Artificiale sviluppati negli ultimi anni abbiano “copiato” le procedure di adattamento dei sistemi viventi (“algoritmi genetici”). Ad esempio i programmi antivirus installati sui PC sono stati sviluppati con le stesse logiche di funzionamento del sistema immunitario, mentre le colonie di formiche hanno ispirato gli algoritmi utilizzati per ottimizzare il trasferimento voce/dati nei telefoni cellulari o per individuare i percorsi ottimali di consegna dei vettori.

Il dilemma tra esplorazione e sfruttamento in azienda

a necessità di trovare un equilibrio tra esplorazione e sfruttamento all’interno delle organizzazioni aziendali è stata analizzata dal sociologo della Stanford University James March nel celebre studio Exploration and Exploitation in Organizational Learning.

Secondo March, le aziende che puntano solo sull’esplorazione (focus prevalente su R&D e Innovazione) non sono in grado di mettere a frutto i risultati della ricerca: generano troppe idee che non vengono sviluppate e troppo poche competenze distintive. Al contrario, focalizzandosi solo sullo sfruttamento (focus prevalente su Sviluppo Prodotti e Commerciale), ci si trova quasi subito intrappolati in equilibri subottimali. Il fatto è che all’interno delle aziende le due attività competono per risorse scarse e i manager compiono esplicitamente o implicitamente una scelta a favore di una delle due.

L’essenza dell’attività di sfruttamento è quella di rifinire ed estendere le competenze, le tecnologie e i processi esistenti. Il suo rendimento in termini finanziari è quindi positivo, prevedibile e a breve termine.

L’esplorazione prevede invece la ricerca, spesso casuale, di nuove alternative: il ritorno economico è incerto, quasi sempre a lungo termine e molto spesso negativo.

E’ quasi naturale quindi che gran parte dei manager, specie se con visioni di breve periodo, tendano a preferire l’exploitation per incrementare la visibilità e la stabilità dei risultati aziendali. Tuttavia, secondo March, questa propensione è potenzialmente auto-distruttiva: senza esplorazione le aziende si troveranno presto in una situazione in cui non avranno più nulla da sfruttare!

“Visto che i vantaggi di lungo periodo dipendono dal mantenere un ragionevole livello di esplorazione, queste tendenze a incrementare lo sfruttamento e a ridurre l’esplorazione rendono i processi adattivi potenzialmente auto-distruttivi.” (James G. March)

Come si costruisce l’innovazione

Supponiamo di essere parte del team di ricerca di una scuderia di Formula 1: dobbiamo iniziare la progettazione della macchina per il prossimo campionato. Ci troviamo di fronte ad un problema complesso all’interno di un settore all’avanguardia nel mondo della tecnologia e dell’innovazione.

Per capire come funzionano i processi decisionali in situazioni di questo tipo, Damon Centola, direttore del Network Dynamics Group della Pennsylvania University, suggerisce di utilizzare un modello matematico chiamato “NK model”, sviluppato dal biologo teorico Stuart Kauffman, per interpretare problemi complessi ispirandosi ai modelli evolutivi di combinazione genetica.

N individua il numero di variabili su cui dobbiamo lavorare nel nostro processo di ricerca. Nel caso della F1 supponiamo di avere 5 variabili (N=5): il motore, il telaio, i freni, il serbatoio e l’abitacolo del pilota. K indica invece il livello di interdipendenza tra le variabili: se K = 1 ogni variabile interagisce solo con sé stessa; in sostanza le caratteristiche sono indipendenti. Ma quando K = 2 o assume valori più grandi le cose si complicano (le variabili sono interconnesse). Se incremento le dimensioni del serbatoio incremento il peso della vettura; questo mette sotto pressione il sistema frenante e probabilmente anche l’aereodinamica. Se modifico l’aereodinamica devo modificare anche il modo in cui metto a terra i cavalli del motore e così via. Una macchina di F1 è sicuramente un sistema complesso!

In questa tipologia di situazioni, l’approccio più efficiente è quello di suddividere il problema in un processo iterativo costituito da tante piccole modifiche: proprio come l’evoluzione genetica agisce per mutazioni impercettibili, gli ingegneri andranno ad effettuare un numero elevato di piccoli interventi, modificando una o al massimo due variabili per volta. In questo modo sono in grado di valutare l’impatto delle variazioni effettuate. Ipotizziamo che la base di partenza sia costituita dalla vettura dell’anno precedente: non avrebbe senso costruire ogni anno una nuova macchina partendo da zero.

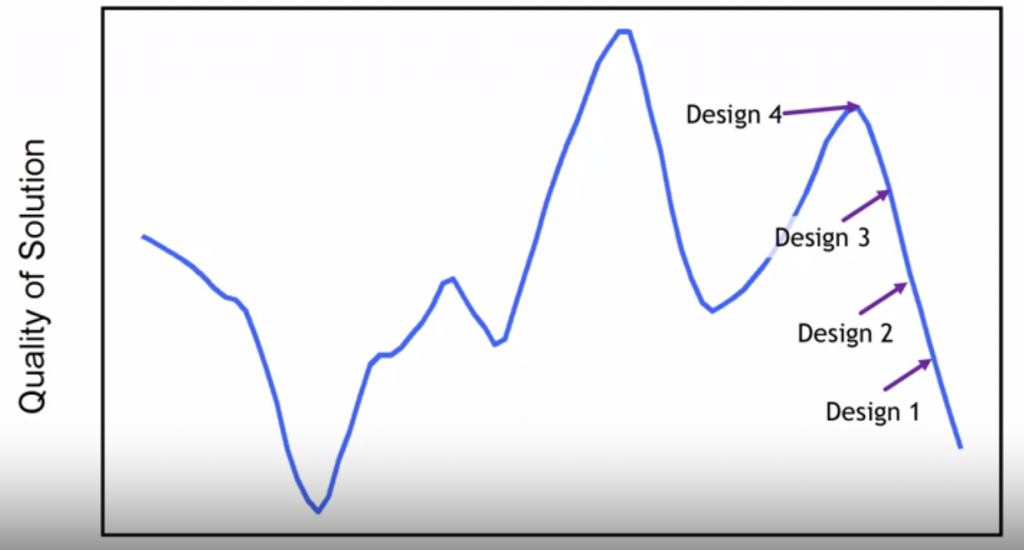

L’andamento del processo di ricerca in un modello NK è raffigurato con un grafico simile a quello della figura 2.

L’asse orizzontale rappresenta l’insieme delle possibili combinazioni delle N variabili del nostro problema mentre quello verticale misura il livello di qualità di ciascuna combinazione (“quality” o “fitness” della soluzione). Supponiamo di partire da una combinazione iniziale “Design 1” (nel nostro esempio la configurazione con cui la macchina ha terminato l’anno precedente): iniziamo ad apportare tanti piccoli cambiamenti che il pilota prova in pista fornendoci dei feedback. Fortunatamente i suoi tempi di percorrenza iniziano a migliorare (iniziamo a spostarci da Design 1 a 2, poi a 3 etc). Ad un certo punto, i miglioramenti si interrompono, il pilota non abbassa più il tempo sul giro: siamo arrivati al Design 4, che rappresenta un “massimo locale”. Da quel punto piccoli cambiamenti portano a peggioramenti: siamo in una situazione di stallo. Osservando la mappa di figura 2 possiamo vedere che si potrebbero raggiungere risultati migliori ed elevare ulteriormente la qualità (c’è un altro massimo più alto spostato a sinistra, il “massimo globale”). Questo però comporterebbe effettuare cambiamenti radicali nella combinazione delle variabili che sposterebbe la configurazione su un punto molto differente della mappa di figura 2. Altro fattore critico: gli ingegneri non hanno a loro disposizione la mappa! Se effettuano cambiamenti radicali non sanno dove atterrano. Per questo nessun team di ricerca e sviluppo si prende il rischio di procedere per salti (“leaps”): il salto potrebbe portare su un punto della mappa fortemente peggiorativo. Oppure anche nel caso in cui fossero fortunati e si spostassero sul versante della montagna con il picco più alto, non sarebbero in grado di capire perché i risultati sono migliorati: nel “salto” hanno modificato troppe variabili contemporaneamente. Non riescono a consolidare i progressi e a costruire ulteriori innovazioni.

“Chiunque sostenga di essere in grado di fare qualcosa di grande è sospetto, e chiunque voglia cambiare il mondo dovrebbe essere più umile. I piccoli miglioramenti incrementali sono l’unica strada sicura per il progresso.” (Peter Thiel)

Una regola chiave dei processi di innovazione è quella di procedere per piccoli miglioramenti incrementali e non per salti: il campionato di Formula 1 si vince nei test invernali quando viene sviluppata la macchina ed i piloti compiono migliaia di giri di prova per testare le diverse configurazioni.

C’è però il problema del “massimo locale”: si arriva spesso ad un punto in cui non si riesce più a migliorare. Quante volte abbiamo visto una macchina di F1 arrivare ad un punto di stallo dal quale ulteriori tentativi di sviluppo sono risultati inutili. La spiegazione fornita è la seguente: il progetto è nato sbagliato in partenza, è stato migliorato progressivamente ma non è stato sufficiente. Gli ingegneri non hanno più tempo per tornare indietro e partire da presupposti differenti (da un punto diverso sulla mappa). Si devono accontentare del massimo locale e molto spesso non basta per vincere il campionato: un’altra squadra ha scoperto il percorso per raggiungere il picco più alto.

La regola delle due pizze (“two pizza rule”)

Per capire come affrontare il problema del “massimo locale”, ritorniamo all’esempio dei sistemi viventi descritti in precedenza. L’attività di ricerca ha un carattere casuale e molti percorsi vengono esplorati in parallelo: le formiche vanno in esplorazione in molte direzioni diverse e i linfociti partono da configurazioni iniziali dei recettori molto diversificate.

Supponiamo che il campionato di F1 preveda la partecipazione di 10 squadre. 10 diversi team di ingegneri che ogni anno nei test invernali partono da configurazioni diverse (diversi punti sulla mappa). Le informazioni sono top secret: non c’è scambio di dati tra Mercedes e Ferrari. E quando una scuderia prova a “copiare” una caratteristica di un’altra vettura ormai è troppo tardi oppure quella variazione si sposa male con la configurazione della propria. Ogni anno una o due scuderie trovano una configurazione vincente, raggiungendo il massimo assoluto ottenibile date le regole del gioco.

Cosa accadrebbe invece se gli ingegneri delle diverse squadre potessero parlare tra loro e ci fosse uno scambio continuo dei risultati dei test e degli sviluppi? Molto probabilmente dopo qualche sviluppo iniziale, i 10 progetti tenderebbero a convergere. Gli ingegneri sarebbero condizionati dai risultati ottenuti dai colleghi delle altre squadre; ci sarebbe un forte incentivo ad abbandonare quasi subito strade che se esplorate maggiormente potrebbero portare a risultati promettenti (siamo sulla parte bassa della montagna più alta del grafico) per seguire l’approccio dell’altro team di ingegneri che sembra da subito più promettente (siamo sulla parte media della montagna bassa) ma che magari tenderà a plafonarsi dopo un breve periodo di sviluppo. In sostanza ci sarebbe un forte rischio che nessuno dei team riesca a raggiungere il massimo assoluto sviluppando la migliore macchina possibile.

“Non avrei mai concepito la mia teoria se avessi avuto maggiore familiarità con i principali sviluppi che stavano accadendo nel campo della fisica.” (Michael Polanyi)

In un sistema in cui le informazioni sono molto diffuse, c’è il rischio di sviluppare comportamenti imitativi che mettano a repentaglio le diversità delle soluzioni, facendo morire sul nascere percorsi di esplorazione potenzialmente vincenti.

Jeff Bezos, negli “early days” di Amazon, aveva istituito la “regola delle 2 pizze (“two pizza rule”): mai fare riunioni con un numero di partecipanti che non potrebbero essere saziati con due pizze.

Per favorire il processo di innovazione, Bezos aveva organizzato le persone in piccoli gruppi di lavoro disincentivando il coordinamento e l’interazione tra gli stessi: questo approccio è servito per preservare le diversità di pensiero e ha favorito lo sviluppo parallelo di tanti progetti che si sono rivelati vincenti. E’ il caso per esempio di Amazon Web Services (AWS) la divisione di Cloud computing che oggi vende servizi anche ad aziende terze (come Netflix) o di Amazon Marketplace che ha ricavi pari a circa il 20% del totale. O più recentemente della divisione di AI dove Amazon sta diventando un leader di mercato.

Il messaggio è chiaro anche se in apparenza controintuitivo: un eccesso di efficienza nella distribuzione delle informazioni all’interno di un’azienda è un fattore negativo per l’innovazione, soprattutto in contesti di gioco con problematiche complesse dove occorre favorire un’attività di esplorazione, che almeno in fase iniziale, deve prevedere diverse opzioni sviluppate in parallelo.

I segreti del cambiamento

Siamo molto fortunati: le strategie per un’efficace gestione del processo di cambiamento sono già stati testate con successo nelle ultime migliaia di anni da gran parte dei sistemi viventi.

Qual è la lezione per le aziende? Mantenere un giusto bilanciamento tra le attività di ricerca (“exploration”) e quelle di sviluppo e commercializzazione (“exploitation”) in presenza di una naturale tendenza dei manager a favorire le seconde per massimizzare profittabilità aziendale di breve periodo.

Nelle attività di ricerca si dovrebbe tollerare un certo livello di casualità e incentivare l’utilizzo di approcci e percorsi diversificati, almeno nelle fasi iniziali di sviluppo di un progetto. In questo senso una condivisione troppo pervasiva delle informazioni potrebbe avere impatti negativi sull’innovazione perché potrebbe generare comportamenti imitativi e di “group thinking”.

Bibliografia

Centola, Damon. Network Dynamics of Social Behavior, University of Pennsylvania, Coursera.org

Hern, Alex. The two-pizza rule and the secret of Amazon’s success. The Guardian, 24 April 2018.

March, James G. Exploration and Exploitation in Organizational Learning. Organization Science, February 1991.

Mitchell, Melanie. Complexity: A Guided Tour. Oxford University Press, 2011.

Thiel, Peter. Zero to One: Notes on Startups, or How to Build the Future. Virgin Books, 2015.

[…] una delle regole chiave è l’equilibrio tra attività di esplorazione e sfruttamento (leggi anche Da Darwin a Amazon: le regole del cambiamento), Page e Brin hanno da subito capito l’esigenza di trovare un giusto bilanciamento tra progetti […]

[…] Articolo originariamente pubblicato su ThinkinPark. […]